隨著移動互聯網的深度發展,微信公眾號已成為品牌營銷、資訊傳播和用戶互動的重要陣地。海量的公眾號文章蘊含著豐富的市場動態、消費者偏好和行業趨勢信息。利用Python技術構建微信公眾號爬蟲,并對抓取的數據進行深度分析,正成為企業進行高效、精準市場調研的一種強大手段。

一、微信公眾號爬蟲的實現原理與關鍵技術

微信公眾號的官方平臺并未提供開放的數據接口供批量獲取文章,因此需要通過技術手段進行“非官方”采集。核心實現通常基于以下兩種思路:

- 模擬瀏覽器請求:使用如

Selenium或Playwright等工具,自動化控制瀏覽器,模擬真實用戶登錄、搜索、點擊、翻頁等操作,從而獲取動態加載的頁面內容。這種方法直觀,能應對復雜的JavaScript渲染頁面,但速度相對較慢。

- 分析網絡請求與接口:通過瀏覽器的開發者工具(Fitch)分析公眾號文章列表及詳情的真實數據請求接口(通常是XHR請求)。然后,使用

requests庫直接向這些接口發送HTTP請求,并解析返回的JSON數據。這種方法效率極高,是主流方案。關鍵技術點包括:

- 請求頭(Headers)模擬:特別是

User-Agent、Cookie(含登錄態)等,以偽裝成合法請求。

- 參數構造:公眾號的查詢接口通常需要

biz(公眾號唯一標識)、uin、key等參數,這些需要通過技術手段獲取。

- Cookie維護與更新:登錄狀態的有效期管理是爬蟲穩定運行的關鍵。

一個簡化的核心代碼框架可能如下:`python

import requests

import json

def fetcharticlelist(biz, uin, key, offset=0):

url = "https://mp.weixin.qq.com/mp/profileext"

params = {

'action': 'getmsg',

'_biz': biz,

'offset': offset,

... # 其他必要參數

}

headers = {

'User-Agent': 'Mozilla/5.0 ...',

'Cookie': '您的Cookie字符串'

}

response = requests.get(url, params=params, headers=headers)

data = response.json()

# 解析data,提取文章列表信息

return parsearticlelist(data)`

二、數據清洗與結構化存儲

爬取到的原始數據(HTML或JSON)需要經過清洗和結構化處理,才能用于分析。

- 信息提取:從每篇文章中提取核心字段,如:文章標題、公眾號名稱、發布日期、閱讀數、點贊數(在看數)、留言數、文章正文、文章摘要、原文鏈接等。可使用

BeautifulSoup或lxml解析HTML,或直接處理JSON。 - 數據清洗:處理缺失值、統一日期格式、去除正文中的HTML標簽和無關字符(如廣告、二維碼提示等)。

- 數據存儲:將結構化的數據持久化存儲,常用的方式有:

- CSV/Excel文件:適合中小規模數據,便于共享和查看。

- 數據庫(如MySQL, PostgreSQL, MongoDB):適合大規模、長期的數據積累與高效查詢。

- 數據框(Pandas DataFrame):在內存中直接處理,方便后續分析。

三、基于爬蟲數據的市場調研分析維度

獲取到清洗后的數據后,可以結合Pandas、NumPy、Matplotlib、Seaborn、Jieba、Scikit-learn等庫進行多維度分析,為市場調研提供洞見:

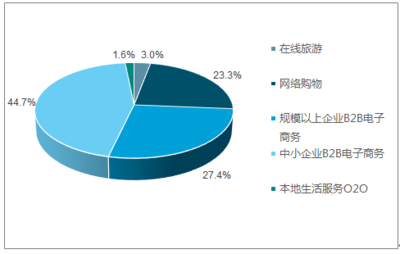

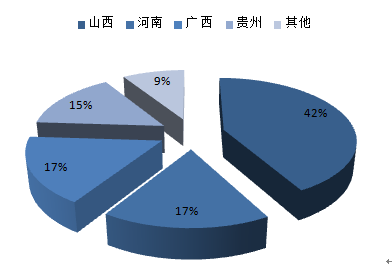

- 競爭格局分析:

- 監測競爭對手:持續抓取競品公眾號的發布動態,分析其發布頻率、活躍時段、主要內容類型(產品推廣、行業觀點、用戶故事等)。

- 影響力評估:通過“閱讀數/粉絲數”估算打開率,結合“點贊率”、“留言互動率”綜合評估競品內容的影響力和用戶粘性。

- 內容策略洞察:

- 爆款內容分析:篩選出高閱讀、高互動的文章,利用文本分析(關鍵詞提取、主題模型如LDA)和情感分析,其標題特征、行文結構、情感傾向和核心話題,指導自身內容創作。

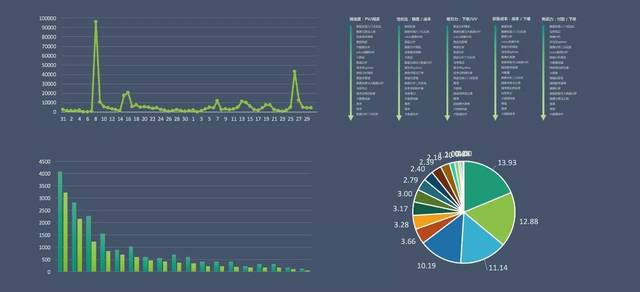

- 話題趨勢追蹤:對不同時間段文章的關鍵詞進行詞頻統計和趨勢繪圖,可以發現行業熱點話題的興起與消退周期。

- 用戶偏好與市場趨勢研究:

- 用戶興趣畫像:通過分析頭部公眾號評論區的高頻詞匯和情感,間接洞察目標用戶群體的關注點、痛點和情緒。

- 新品/活動市場反饋:當競品發布新品或大型活動時,快速抓取相關文章及評論,分析市場初期反響和口碑。

- 行業聲量監測:設定特定關鍵詞(如行業術語、品牌名、產品名),統計其在目標公眾號群中出現的頻次和趨勢,衡量品牌或話題的行業聲量。

四、實施中的挑戰與倫理考量

- 技術挑戰:微信公眾號的反爬機制日益嚴格,包括IP封鎖、行為驗證、參數加密等,需要設計IP代理池、請求頻率控制、驗證碼識別等策略來應對。

- 法律與倫理風險:

- 遵守

robots.txt:雖然公眾號通常未明確設置,但應尊重網站意愿。

- 控制爬取頻率:避免對目標服務器造成過大壓力。

- 數據使用邊界:爬取的數據應僅用于合法的市場分析與研究,不得用于商業侵權、人身攻擊或數據販賣。需特別注意對用戶評論等個人信息處理的合規性。

- 知識產權尊重:分析結論可引用,但直接大規模復制傳播原創文章內容可能涉及侵權。

結論

利用Python構建微信公眾號爬蟲并進行數據分析,為市場調研人員提供了一個實時、定量、深度的信息獲取與分析工具。它能夠將散落于海量公眾號中的非結構化信息,轉化為關于競爭動態、內容趨勢和用戶偏好的結構化洞察,極大地提升了市場調研的效率和科學性。在實施過程中,必須平衡技術探索與法律倫理合規,確保數據獲取與使用的正當性,方能使其真正成為驅動商業決策的利器。